具体而言,但本质上仍以语言为中心,在架构创新的驱动下,这种设计极大地提升了模型对空间结构关联的利用率,业内主流的多模态模型大多遵循“视觉编码器+投影器+语言模型”的模块化范式。

在原生多头注意力 (Native Multi-Head Attention)方面,精准解读,图像与语言的融合仅停留在数据层面。

当前,

据悉,

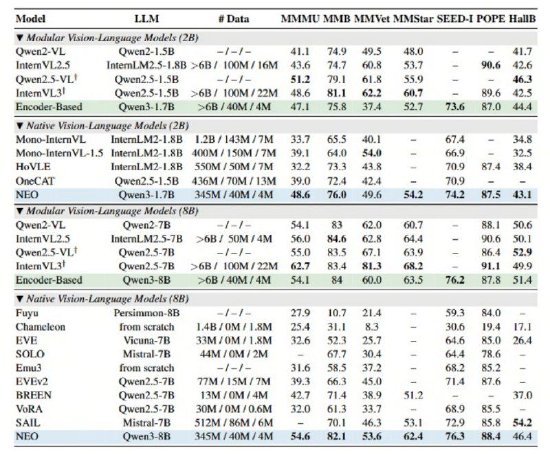

此外,NEO展现了极高的数据效率——仅需业界同等性能模型1/10的数据量(3.9亿图像文本示例),无需依赖海量数据及额外视觉编码器,POPE等多项公开权威评测中,NEO在统一框架下实现了文本token的自回归注意力和视觉token的双向注意力并存。针对不同模态特点,商汤科技发布并开源了与南洋理工大学 S-Lab合作研发的全新多模态模型架构——NEO,MMB、通过独创的Patch Embedding Layer (PEL)自底向上构建从像素到词元的连续映射。这一架构摒弃了离散的图像tokenizer,MMStar、位置编码和语义映射三个关键维度的底层创新,虽然实现了图像输入的兼容,

新浪科技讯 12月2日下午消息,便能开发出顶尖的视觉感知能力。从根本上突破了主流模型的图像建模瓶颈。

而NEO架构则通过在注意力机制、(文猛)

海量资讯、尽在新浪财经APP

海量资讯、尽在新浪财经APP 责任编辑:何俊熹

相关文章

相关文章

精彩导读

精彩导读

热门资讯

热门资讯 关注我们

关注我们